AI深度观察 | 大模型变身“照妖镜”,中文数据现出“散少难”原形

中美两国在领先科技AI大模型领域,正在展开激烈的科技竞赛。未来的决胜因素,定格在算法、算力和数据三个具体赛道。

一直以来,大量业内人士更关注算法、算力因素。原因不难理解,算法是硬核科技,中国落后美国至少半年以上;算力背后是芯片竞争,中国是被规则限制的一方,未来得靠自力更生。然而,随着时间推进,数据的重要程度以及短板,被越来越多的业内人士提及。

“中文大数据现有的一些短板,正在成为我国大模型发展的资源瓶颈。”北京智源人工智能研究院副院长兼总工程师林咏华,近日接受《凤凰WEEKLY财经》采访时表示。她近半年已多次在媒体上表达此观点。

“数据的数量和质量,决定AI大模型一半以上的认知。据我所知,我国大部分AI大模型训练所需的中文数据语料较为短缺,中文语料占英文开源语料的十分之一甚至更少;不仅如此,目前训练所需的高质量的中文语料也面临搜集难、使用门槛过高问题。这到底会为中国的大模型发展带来什么不利因素有待评估。

“但起码导致中国的大量AI大模型的知识主要来源于‘外教’,其与人交流时思维容易偏西式化。在一些泛场景中,文生图时会直接生成外国人。”林咏华说。

无独有偶,国内领先AI大模型“通义千问”的发布者阿里巴巴集团,于5月24日发布研究报告《大模型训练数据白皮书》,也指出高质量大模型训练数据存在数量不足、共享难等现状。

该白皮书进一步认为:“中文语料‘量’的短缺尚可有解决方案,但中式价值观类的语料短缺,则会成为制约我国大模型发展的短板。”

AI大模型,是迄今数据资源最重要、最集中的使用场景,甚至被称为“数据黑洞”。显而易见,通过AI大模型这个“照妖镜”暴露出来的中文大数据短板,同样会影响到我国数字化发展的其他方面。

数据有多重要?其被学界公认为“新质生产力”,是可以与土地、劳动力、资本、技术等并列的生产力要素。我国从2015年起将大数据发展提高到国家战略的地位。

今年5月24日,国家数据局挂牌成立7个月后首次曝出全国数据资源摸底结果:2023年,全国数据生产总量达32.85泽字节(ZB),同比增长22.44%。该总产量高出业界预测,中国进一步坐稳全球第二数据大国地位。

一个矛盾是,作为数据大国的中国,却同时面临“数据短缺”和高质量数据使用难问题。上述数据的信源《全国数据资源调查报告(2023年)》同时指出,“数据有效供给不足”和“数据价值有待释放”成为我国数据资源建设的重要挑战。

2024年1月4日,国家数据局等17部门联合印发《“数据要素×”三年行动计划(2024—2026年)》。规划前瞻性地提出:建设高质量语料库和基础科学数据集,支持开展人工智能大模型开发和训练。

知易行难,中文数据语料问题,破题正当时。

愈加严重的中文数据“互联网孤岛”

AI大模型让中文大数据现出的第一个原形,是“散 ”。

像一枚硬币的两面,移动互联网高速发展十几年后,中文大数据一方面在加速连通,另一方面也在加速分割,加速孤岛化。这给AI大模型抛出了第一道“数据难题”。

《大模型训练数据白皮书》披露,阿里巴巴“通义千问”的中文语料主要来自知乎、百度百科、百度知道等公开网络数据,其中来源于政府的公共数据较少。

一条数据近期在互联网从业者中广为转发,据Web Techmology Surveys 网站,自2013年到2024年11年间的全球主要网站网页内容语言使用历史趋势,中文网页的数量从4.3%下降至1.3%,下降高达70%;而同期英文网站比例则从50.6%上升至60.6%。

该数据之所以广为流传,在于这个数据的魔幻性,让人况味。在中国移动互联网高速发展的十年中,相比英文资讯,中文资讯已越来越“去网页化”,向移动互联网平台高度迁移。

在这十余年中,我国9亿多网民迁移至各类移动互联网平台,例如社交、电商、本地生活、数字政务等,并且中国的迁移程度高于英文世界。而迁移背后,各家移动平台为了建立“数据护城河”,先后主动切断与传统网站网页的数据连通——名为“互联网孤岛”的新型数据孤岛就此产生。

网友列举了主要“互联网孤岛”的产生时间表:

2008年,淘宝屏蔽了百度的收录,称“百度搜索没有带来直接的交易量”。在微信兴起后,淘宝与微信之间更是存在相互的信息屏蔽。

2014年前后,微信拒绝搜狗之外的其他搜索引擎的抓取。而随后数年,腾讯系平台成为我国最主要的内容信息平台之一。

继腾讯、阿里、百度之后崛起的字节跳动,近年成为中国视频内容的绝对王者。其在2021年前后禁止外部对抖音的小视频搜索。

2022年7月,小红书开始打击爬取平台数据行为。最新的消息是,知乎近日开始提出更高的用户登录要求,并拒绝部分外部搜索。

虽然在移动互联网情形下,美国、欧盟也产生了类似的新型数据孤岛,但其情形显然没有中国严重。例如,美国的YouTube可以通过网页搜索,而我国的抖音和快手短视频则不可以。

当然,在AI大模型的发展过程中,中文数据领域的“互联网孤岛”显出其弊端。各家平台的AI大模型一方面拥有自己护城河内的中文数据优势,同时难以摆脱河外的数据劣势。而对于平台之外的大模型,只能在数据方面“自主创业”。

缺少“存盘”的历史中文数据

AI大模型让中文大数据现出的第二个原形,是“少”。

无论是英文世界还是中文世界,历史和近期网站网页内容均是AI大模型最重要的训练语料来源之一。在这方面,英文训练语料的丰富程度强过中文语料。

业内人士认为,除了上文提到的数据迁移现象外,还有两个原因导致了中英文网页训练语料现状。一是英文作为全球“普通话”的天然优势,二是英文网站网页在存量保护方面好于中文。

林咏华通过英文Common Crawl(又称Pile-CC)数据集的故事详解中英文网页语料的区别。Common Crawl是一个海量的、非结构化的、多语言的网页数据集。约17年前,美国一家致力于让普通人和小公司一样可以使用大型数据集的第三方组织,以公益的方式在全球不断爬取网页、积累数据,至今已存有2500多亿的网页。该数据集可供全球研究和开发者免费使用。

最终,无论是OpenAI还是Meta,在训练AI大模型时都基于这个名为Common Crawl的数据集。《大模型训练数据白皮书》中介绍了美国最著名的数据开源组织之一Eleuther AI开发的 825GB 高质量英文语料库 The Pile,其数据集中有227GB由Common Crawl内容构成,占比27%。

事实上,无论是英文网页还是中文网页,都存在因技术、商业等原因导致的存量网站消失情况。但英文世界因为民间力量的存在将历史网页保存下来了,而中文历史网页则缺少类似的民间力量。

“说来挺可惜的,咱们国内等于是AI大模型这个技术潮流来了,才意识到历史网页数据很有价值,是用于训练模型的好物料。可是,这么多年以来,很少有人做过网页的汇聚工作。这些损失,补不回来了。”林咏华说。

“我们发现,中文网页里图片、视频信息失效最快,有时只要过上20来天,图片或视频就打不开或有损坏。”一位参与大模型数据收集的业内人员说。

中文数据利用难

AI大模型让中文大数据现出的第三个原形,是现有数据“利用难”。

政府和国有企事业单位的公共数据是我国大数据的第一“数源”,其现状至少在两个层面制约着AI大模型的数据使用。

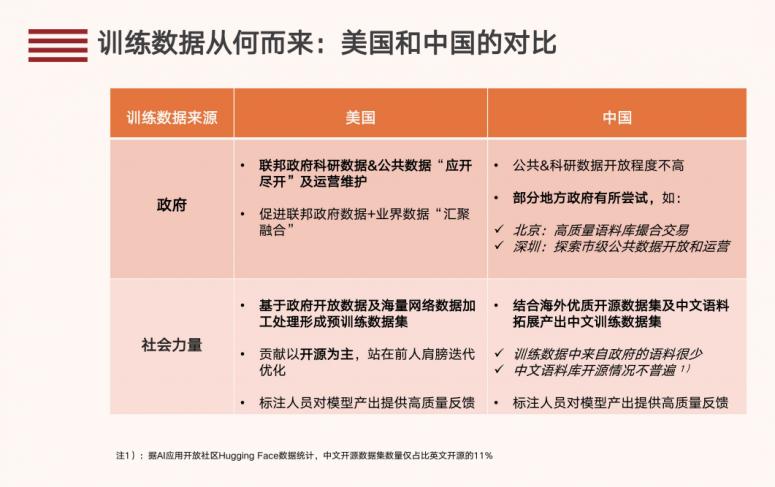

第一个层面是我国公共数据相比美国存在开放不足,从而导致国产AI大模型行业的优质数据供给呈现短缺。

阿里巴巴的大模型训练数据相关研究披露,“我国的公共数据采用主体性质界分,包含各级行政机关在履行公共管理职能中获取的数据,覆盖范围比美国更广,但在开放共享和开发利用程度上仍有不足。

“如天气数据的开放,在中国气象数据网查询地面逐小时观测资料时,个人用户需注册,且可选范围被限定在7天以内;而对比 美国NOAA,无需注册即可下载,且以地表温度为例,数据最早可追溯到1951年。在开发利用中,我国也仅对个别数据集提供了API接口。

“再如法律领域,我国裁判文书网近年公开的数量有明显下降趋势,2020年上网文书2300多万,而2023年截至12月仅公开300万。在医疗领域,对于模型训练价值较高的医疗影像、基因组数据开放程度非常有限。”

图/《大模型训练数据白皮书》

第二个层面是AI大模型的新型用数模式与传统的版权类使用方式有所区别,从而产生新型的“用数难”。

例如,AI大模型训练对论文、文学作品、音乐作品、影视作品等数据的使用,并非是“以欣赏作品原有价值为目的”的利用,也不是对作品内容进行复制、传播,而是为了培训大模型掌握基础智能知识,而现有的期刊论文、音乐、影视相关版权方,则要求大模型训练方按版权使用付费。这对大模型训练而言是难以承受的负担。

目前,欧盟和日本等已先行一步,试图推行AI大模型使用版权物料的低价甚至免费办法。

中文数据短板的可能后果:大模型的西式思维

曾任职IBM中国研究院院长、观察和研究中美AI行业多年的林咏华说:“中文数据物料的供给不足,对中国每一个大模型的训练都有较大的影响。据我了解,国内大模型目前的训练以英文开源语料为主。”

《大模型训练数据白皮书》显示,阿里巴巴的“通义千问”AI大模型,训练数据来自公共开源的混合数据,以中文和英文为主。报告没有透露“通义千问”中英文训练语料的比例,但指出“从总体看,中文语料库的开源情况不如英文普遍,据AI应用开放社区 Hugging Face数据统计,中文开源数据集数量仅占英文开源的11%。”

通义千问官网界面截图

在谈到中文语料不足,对国产AI大模型带来的可能后果时,业界认为首先是喝“洋墨水”太多带来的“水土难服”问题。国产大模型的主战场终究是中国市场,模型应用“本土化”是必须的。目前业内解决办法,一般是让大模型将占比不大的中文数据“多学习几遍”,以及次序上优先学习中文数据。事实上,这是全球范围内的小语种大模型的通用做法。

第二个后果就是国产AI大模型不够“中国化”。即大模型生成的文本,思维偏西方化,中式风格不足。“文生图尤其应该关注,不少模型图片里的中国人偏西方化,或者更像西方人眼中的中国人。如果请国产大模型生成一些办公场景、商业场景,往往会出现不少外国面孔。”

“代表中式价值观的语料有助于大模型更好地理解和反映中文使用者的文化背景和价值取向,从而在在全球化的背景下保持文化的多样性和独特性。其短缺的问题也没有办法通过机器翻译弥补,因为即使翻译质量有保障,仍会引入源语言的偏见,体现的仍是源语言的价值观。”《大模型训练数据白皮书》如是说。

如何破局中文数据“散少难”

针对中文数据领域的“散少难”困局,浙江省数字经济学会常务副会长章丰接受《凤凰WEEKLY财经》采访时表示,我国政府对大数据战略、对AI大模型发展的重视是足够的,相信现有困局其实是发展中的问题,会被逐浙解决。“不过我认为问题的解决,主要还要靠市场方式和社会力量,政府可以更多在政策和制度层面破题。”

章丰说,英文世界的网页数据被保存下来,并不是因为政府规划和管理,也不是因为谷歌、微软这些大企业做了什么工作,而是被第三方公益组织出于数据公益目的保存的。中文网页或许在过去网页挽救方面做不了什么,但未来网页则可以发动社会力量比如数据基金组织、行业协会等进行保存。

对于“互联网数据孤岛”以及用数难问题,章丰认为其出路在于市场机制。他举了瓴羊智能科技有限公司的例子,该公司是阿里巴巴旗下的数据服务企业,对外提供一整套数字化产品,这说明大型互联网企业有动力推动数据资源的有效利用。

林咏华透露,北京智源人工智能研究院近一年联合全国数十家头部互联网企业、大模型企业、数据提供企业,还有国家和北京市的相关机构,一起探索了三种AI大模型数据共享方式。第一种是打造一个完全开源的高质量中文数据集,目前有2.4TB数据。第二种共建共享数据模式,近30家互联网企业纳了数据“投名状”,获得联盟积分来分级共享各家数据。第三种是“数算一体”方式,对高质量有版权的数据,大模型团队可以在平台上进行模型训练,完成后不带走数据但可带走模型。

“但这只是开始,深层次问题还需要沿着这个方向继续探索。”林咏华说。

章丰十分赞赏北京智源的数据共享模式,认为未来各家互联网企业可以搞类似“G7、G20”这样的数据联盟,“大家体量差不多,数据价值都大,联合在一起利用安全数据技术使用彼此数据,当然是可以探讨的。”

章丰说,目前数据共享的科技已经相对成熟或者接近成熟。“其实我国各地、各级政府在数据汇集、数据开放方面已经做了很多工作了。”他以“厨师做菜”的比喻介绍了浙江省正在试行的公共数据开放工作。公共数据好比是蔬菜,正在逐步对外开放大量汇集来的菜汇集在一个政府设定的安全、分类分级的‘厨房’里,社会的用数主体就像厨师,你来申请用数并提出用数方案,经同意后厨师可以在厨房里做菜,做完后厨师离开时可以把成品菜带走。“这种方式类似北京智源推出的‘数算一体’方式。这种方式是数据开放的初始模式,未来可以利用技术手段更加开放。”

中国是一个不折不扣的数据大国,数据生产总量占全球总量近乎四分之一,且数据增长速度呈加速态势。“现在的课题是怎么让数据大国成为数据强国,让数据动起来、用起来,价值发挥出来。AI大模型提供了一个非常好的用数大场景,可以倒逼中文数据的‘产存算,供流用’各个环节补短板、增效率。”一位资深业内人士表示。